OpenAIが、NVIDIAの最新データセンターGPU「Blackwell B200」を搭載した「DGX B200」プラットフォームを導入したことが明らかになりました。この動きは、AI開発の世界に大きな変革をもたらす可能性があります。

OpenAIは公式Xアカウントで、エンジニアリングサンプルの一つとしてDGX B200が社屋に届いたことを発表しました。これにより、同社は最先端のAIモデルのテストとトレーニングを開始する準備が整ったことになります。

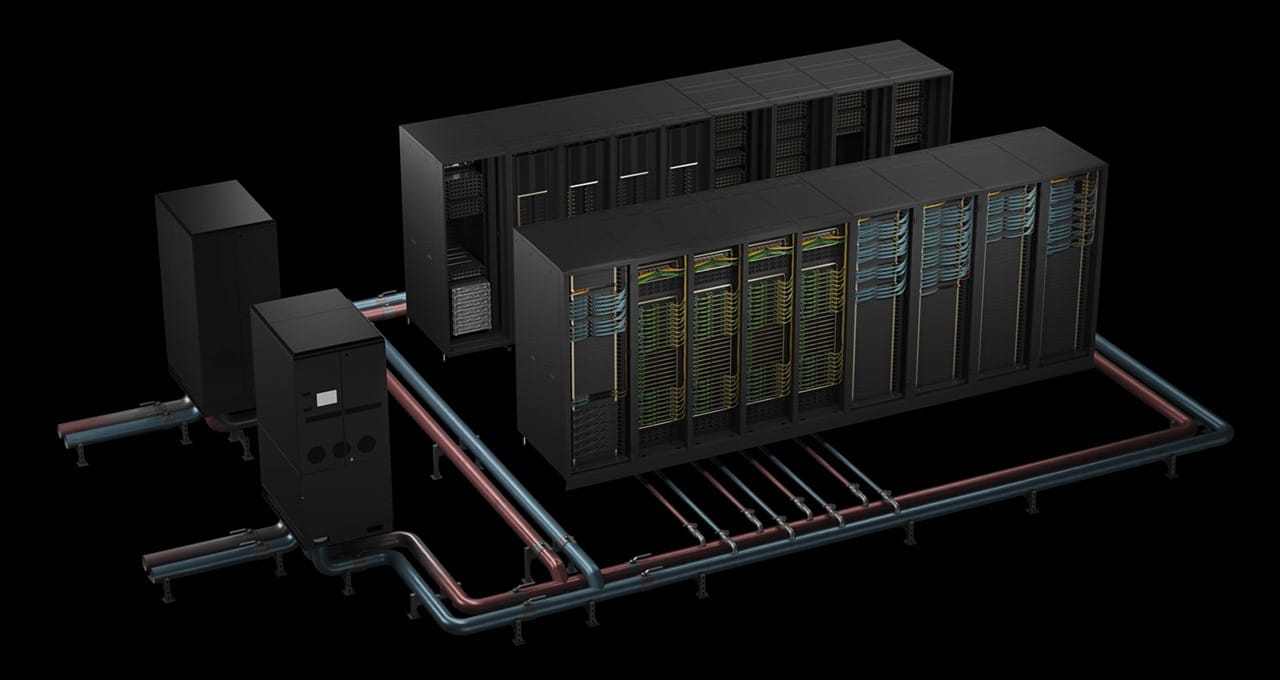

DGX B200は、AIのトレーニング、ファインチューニング、推論を統合的に行うためのプラットフォームです。8基のB200 GPUを搭載し、最大1.4TBのGPUメモリと64TB/秒のHBM3Eメモリ帯域幅を提供します。NVIDIAによると、DGX B200は最大72ペタFLOPSのトレーニング性能と144ペタFLOPSの推論性能を発揮し、AIモデルにとって驚異的な性能を実現します。

Blackwell B200の圧倒的な性能

Blackwell B200は、NVIDIAが今まで生産した中で最速のデータセンターGPUです。OpenAIのCEOであるサム・アルトマン氏も以前からBlackwell GPUに強い関心を示していました。

「Blackwellは大幅な性能向上を提供し、最先端モデルの提供能力を加速させます。NVIDIAと協力してAIコンピューティングを強化できることを楽しみにしています」とアルトマン氏は述べています。

AI業界のトレンド:Blackwell B200の採用拡大

OpenAI以外にも、Amazon、Google、Meta、Microsoft、Tesla、xAI、Dell Technologiesなど、多くの大手企業がBlackwell B200 GPUを採用してAIモデルのトレーニングを行う予定です。特にxAIは、現在導入している100,000台のH100 GPUに加えて、50,000台のB200 GPUの使用を計画しています。

また、Foxconnは台湾最速のスーパーコンピューターをB200 GPUで構築すると発表しました。このように、Blackwell B200の需要は急速に高まっています。

DGX B200がもたらす革新的な性能向上

NVIDIAによると、DGX B200は前世代と比較して、トレーニング性能が3倍、推論性能が15倍向上しています。これにより、大規模言語モデル(LLM)、チャットボット、レコメンデーションシステムなど、様々なAIアプリケーションの処理が可能になります。

OpenAIにとって、Blackwellの導入は単なる性能向上以上の意味を持ちます。より高速なコンピューティングニーズに対応できるだけでなく、NVIDIA Hopper GPUと比較してはるかに優れた性能と電力効率を実現できます。

まとめ

OpenAIによるNVIDIA DGX B200の導入は、AI開発の新時代の幕開けを象徴する出来事です。最先端のGPU技術を活用することで、AIモデルの開発と運用が大幅に加速され、より複雑で高度なAIアプリケーションの実現が期待されます。今後、他の企業や研究機関もBlackwell B200の採用を検討する可能性が高く、AI技術の進化がさらに加速することでしょう。

この技術革新がAI業界全体にどのような影響を与えるのか、今後の展開に注目が集まります。